拥抱故障:为何云原生网络功能(CNF)韧性是可靠5G网络的基石

随着5G网络向云原生架构转型,将韧性构建到云原生网络功能(CNFs)中对于确保可靠性、服务连续性和运营敏捷性至关重要。

——

云原生范式的转变

5G网络正在经历一场深刻的变革——从基于硬件的基础设施向云原生架构迁移。这一转变带来了可扩展性、灵活性和敏捷性的承诺。然而,它也引入了新的复杂性,特别是在可靠性方面。云原生网络功能(CNFs)是这一演进的核心。它们优雅地处理故障的能力,定义了5G网络的真正韧性。

在传统的电信基础设施中,硬件故障往往意味着整个系统的停机。相比之下,CNFs被设计为能够在运行中动态恢复、重启和重新配置。然而,要实现这种级别的稳健性,需要深思熟虑的设计选择、严格的测试,以及将故障视为运营模型一部分的心态。

理解CNF韧性

CNF韧性指的是这些软件功能在面临故障时(无论是在进程、Pod、节点还是服务层面)能够承受并恢复的能力。与单一的应用不同,CNFs在容器化环境中运行,其中像Kubernetes这样的编排平台管理着它们的生命周期。然而,这种编排并不天生保证韧性,它只是提供了工具。CNF的真正韧性取决于它的构建方式、在压力下的行为方式,以及它如何与周围的生态系统集成。正确的架构和运营选择,可以在优雅恢复和灾难性服务中断之间产生天壤之别。

为何CNF故障是不可避免的——也是必要的

故障不再是一种必须不惜一切代价避免的异常情况。在云原生环境中,故障是意料之中的——甚至被视为系统正常行为的一部分而被接受。容器会崩溃,Pod会重启,节点会变得不可用。重要的是,不是故障是否会发生,而是系统如何响应。

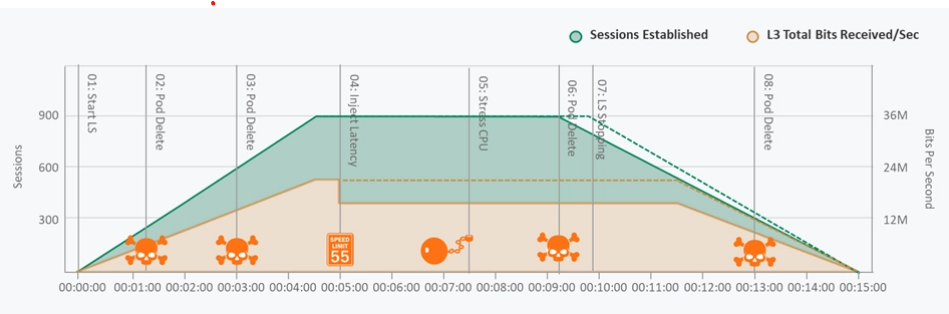

基于故障的测试,即故意对CNFs施加压力、剥夺其资源或使其处于混乱场景中,是韧性验证过程中的一个关键部分。

故障不再是一种必须不惜一切代价避免的异常情况。在云原生环境中,故障是意料之中的——甚至被视为系统正常行为的一部分而被接受。

如果不进行这些测试,就无法验证云原生网络功能(CNF)在实际情况下是否会按预期表现。一个在理想条件下表现良好但在压力下崩溃的CNF,无法被信赖来支持关键任务的5G服务。

针对CNF韧性的全面方法必须考虑多个维度:

资源可用性:评估在CPU、内存或存储受限条件下的行为。

进程韧性:确保当容器崩溃时,CNF能够自主重启或恢复。

编排行为:验证Kubernetes(或其他编排器)是否已正确配置,以便在中断期间重新平衡工作负载并保持服务可用性。

服务连续性:测试在故障情况下服务网格和流量重定向等回退机制。

依赖管理:评估CNF如何处理上游或下游服务中的故障,而不会引发连锁性停机。

在实际故障场景中的韧性

设计具有韧性的CNF需要在广泛的故障场景中进行验证。例如,在CPU或内存受限的情况下,CNF应优先处理核心功能,而不是意外崩溃。当容器崩溃时,它们应干净地重启,理想情况下不会丢失状态或影响其他服务。同样,如果Pod被驱逐或节点宕机,编排器必须有效地重新分配工作负载以保持连续性。具有韧性的CNF还应能够优雅地处理外部依赖项(如数据库或信令服务)的丢失,使用重试、断路器或回退路径。这些行为对于确保正常运行时间和可靠性至关重要,特别是在网络规模扩大和软件更新变得更加频繁的情况下。

测试与验证:让韧性成为现实

将韧性构建到云原生网络功能(CNF)中只是开始。通过持续测试来证明其韧性,才是真正的保障所在。可观测性工具、日志系统和监控平台虽然必不可少,但它们只能描述系统的状态,而无法在故障条件下验证其行为。真正的韧性测试必须超越监控,必须模拟现实世界中的故障事件,并评估CNF的响应。这包括引入故障、观察恢复情况、衡量性能下降,并从用户角度确保服务连续性。理想情况下,这些测试应集成到持续集成/持续部署(CI/CD)管道中,确保每次新的代码推送或基础设施变更都能自动验证其韧性。这种主动的方法降低了风险,并增强了人们对系统处理意外情况能力的信任。

人为因素:培养韧性心态

具有韧性的CNF不仅需要技术上的卓越,还需要心态上的转变。团队必须将故障视为学习、改进和强化系统的机会,而非威胁。开发者、测试者和运维人员必须就故障场景、测试覆盖范围和恢复指标进行协作。韧性必须被视为一项一流特性,在整个开发生命周期中保持关键绩效指标(KPI)的一致性。这种文化上的转变使组织能够更快地行动、更可靠地交付,并在面对复杂故障时保持信心。通过将故障正常化,团队可以在无惧的情况下进行创新、更快地迭代,并最终为用户和企业带来更好的成果。

在5G世界中,实时服务、自动化和用户期望不断攀升,韧性并非可选,而是基础。CNF是云原生网络的动力引擎,其生存、恢复和适应的能力决定了整个系统的质量和可靠性。通过分层架构、严格的故障测试以及文化上对韧性的接纳,组织可以实现现代电信运营所需的稳健性。